Dans un billet de blog, Meta explique que le contenu nuisible peut évoluer rapidement sur ses réseaux sociaux et a donc décidé de mettre en place une technologie d’intelligence artificielle qui est capable de comprendre un sujet et d’utiliser beaucoup moins de données étiquetées pour apprendre de nouvelles tâches.

Le groupe indique que les contenus problématiques (violence, complotisme…) sont toujours en constante évolution et sont alimentés par des événements spécifiques ou bien par des personnes à la recherche de nouveaux moyens d’échapper aux systèmes déjà mis en place par Meta. Il apparaît donc important pour le géant américain de développer ses technologies d’IA en parallèle.

Mais il faut généralement plusieurs mois pour collecter et étiqueter des milliers voire des millions de données nécessaires pour former chaque système d’intelligence artificielle à détecter un nouveau type de contenu.

Une technologie baptisée Few-Shot Learner

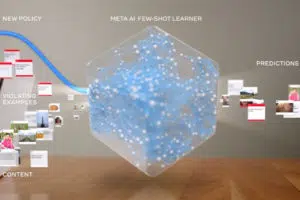

Face à cette problématique de temps de détection trop long, Meta a conçu et déployé « Few-Shot Learner » (FSL). Il s’agit d’une technologie d’IA qui peut s’adapter pour prendre des mesures sur des types de contenus nuisibles (nouveaux ou en évolution) en quelques semaines au lieu de quelques mois. En fait, ce système utilise une méthode d’apprentissage qui commence par une compréhension générale de nombreux sujets, puis les données sont beaucoup moins utilisées afin que le système apprenne de nouvelles règles de filtrage.

« Le FSL peut être utilisé dans plus de 100 langues et apprend à partir de différents types de données, telles que des images et du texte. Cette nouvelle technologie contribuera à augmenter nos méthodes existantes de lutte contre le contenu nuisible. » – Meta

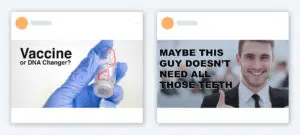

Le groupe Meta a testé sa nouvelle technologie sur plusieurs événements récents. Des contenus problématiques ont par exemple été identifiés concernant des informations trompeuses ou sensationnalistes pour décourager sur la vaccination du COVID-19. Le système d’IA a par ailleurs réussi à détecter des contenus qui se rapprochent de l’incitation à la violence alors que les formulations pouvaient être implicites.

La firme de Mark Zuckerberg estime que sa nouvelle technologie pourra au fil du temps améliorer les performances de tous ses systèmes d’IA afin de traiter de nombreux types de violations de ses règles.

Soyez le premier à poster un commentaire

Partagez votre avis et participez à la discussion en laissant un commentaire ci-contre.